В те старые добрые времена, когда владельцы персональных компьютеров активно использовали громадные ЭЛТ-мониторы, зарабатывая себе астигматизм, о плавности изображения никакой речи идти не могло. Тогдашние технологии не очень поддерживали и 3D. Поэтому бедным юзерам приходилось довольствоваться тем, что было. Но время идет, технологии развиваются, и многих уже не устраивает разрыв кадра (тиринг) при динамической игре. Особенно это касается так называемых кибер-спортсменов. В их случае доли секунды решают все. Как быть?

Прогресс на месте не стоит. Поэтому то, что раньше казалось невозможным, сейчас может восприниматься как должное. Та же ситуация и с качеством изображения на компьютере. Производители видеокарт и других комплектующих к ПК сейчас вовсю трудятся над проблемой некачественного вывода изображения на мониторы. И, надо сказать, что они уже довольно далеко продвинулись. Остается самая малость, и изображение на мониторе станет идеальным. Но это все — лирическое отступление. Вернемся к нашей основной теме.

Немного истории

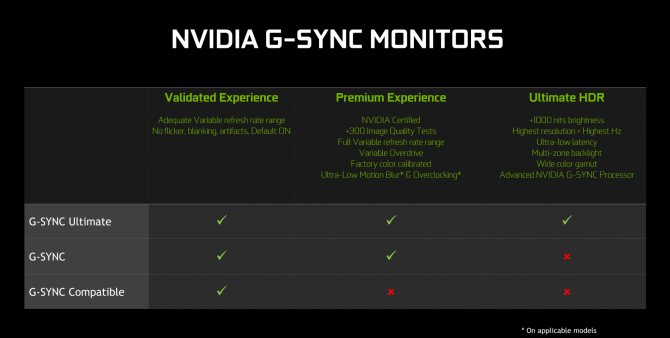

Многие производители видеокарт и мониторов активно пытались побороть тиринг и улучшить изображение. Что только они не изобретали: повышали «герцовость» монитора, включали V-Sync. Ничего не помогало. И в один прекрасный день известный производитель видеокарт NVIDIA презентует технологию G-Sync, с помощью которой можно добиться «нереальной» плавности изображения без всяких артефактов. Вроде бы и хорошо, но имеется одно маленькое, но очень серьезное «но». Для пользования этой опцией нужны мониторы с поддержкой G-Sync. Пришлось поднапрячься на рынок пару десятков моделей. А что дальше? Давайте рассмотрим технологию и попробуем разобраться, так ли она хороша.

V-Sync на интегрированной видеокарте Intel HD Graphics

Если используем интегрированный чип Intel HD Graphics, также доступна панель управления. Она должна быть доступна при нажатии правой кнопкой мыши на рабочем столе или через комбинацию клавиш Ctrl + Alt + F12.

На панели Intel переходим на вкладку Режим настройки – Панель управления — Трехмерная графика, а затем в пользовательские настройки.

Здесь находим поле с синхронизацией по вертикали Vertical Sync. Можно включить ее принудительно, установив значение на «Включено» или установить на «Настройки приложения». К сожалению, в опциях карты Intel HD нет функции принудительного отключения – только можно включить V-Sync. Так как отключить вертикальную синхронизацию в видеокарте не представляется возможным, то сделать это можно только в настройках самой игры.

Что собой представляет G-Sync?

G-Sync – технология вывода цифрового сигнала на экран от компании NVIDIA. Характеризуется плавностью смены кадров без всяческих артефактов. Нет ни разрывов изображения, ни подтормаживаний. Для адекватной работы сей технологии требуется довольно мощный компьютер, поскольку для обработки цифрового сигнала нужны немаленькие мощности процессора. Именно поэтому технологией снабжаются только новые модели видеокарт от NVIDIA. Кроме того, G-Sync – фирменная фишка NVIDIA, поэтому владельцам видеокарт от других производителей ничего не светит.

Кроме мощного ПК, требуется G-Sync-монитор. Дело в том, что такие мониторы оснащены платой с преобразователем цифрового сигнала. Владельцы обычных мониторов не смогут воспользоваться этой восхитительной опцией. Несправедливо, конечно, но такова политика современных производителей – выкачать как можно больше денег из бедного пользователя. Если конфигурация вашего ПК позволяет использовать G-Sync, и монитор чудом поддерживает эту опцию, то вы вполне можете оценить все прелести данной технологии.

Принцип работы G-Sync

Попробуем упрощенно объяснить принцип работы G-Sync. Дело в том, что обычный GPU (видеокарта) просто посылает цифровой сигнал на монитор, но не считается с его частотой. Именно поэтому сигнал при выводе на экран получается «рваным». Сигнал, идущий от GPU, прерывается частотой монитора и выглядит неказисто в конечном варианте. Даже с включенной опцией V-Sync.

При использовании G-Sync GPU сам регулирует частоту монитора. Именно поэтому сигналы доходят до матрицы тогда, когда это действительно нужно. Благодаря этому появляется возможность избежать разрывов изображения и повысить плавность картинки в целом. Поскольку обычные мониторы не позволяют GPU управлять собой, был придуман G-Sync-монитор, в который внедрена плата от NVIDIA, регулирующая частоту. Поэтому использование обычных мониторов невозможно.

⇡#Методика тестирования

Монитор ASUS ROG SWIFT PG278Q был протестирован по нашей новой методике. Мы решили отказаться от медлительного и порой неточного Spyder4 Elite в пользу более быстрого и точного колориметра X-Rite i1Display Pro. Теперь для измерения основных параметров дисплея будет использоваться этот колориметр совместно с программным комплексом Argyll CMS последней версии. Все операции будут осуществляться в Windows 8. Во время тестирования частота обновления экрана составляет 60 Гц.

В соответствии с новой методикой мы измерим следующие параметры монитора:

- Яркость белого при мощности подсветки от 0 до 100% с шагом 10%;

- Яркость чёрного при мощности подсветки от 0 до 100% с шагом 10%;

- Контрастность дисплея при мощности подсветки от 0 до 100% с шагом в 10%;

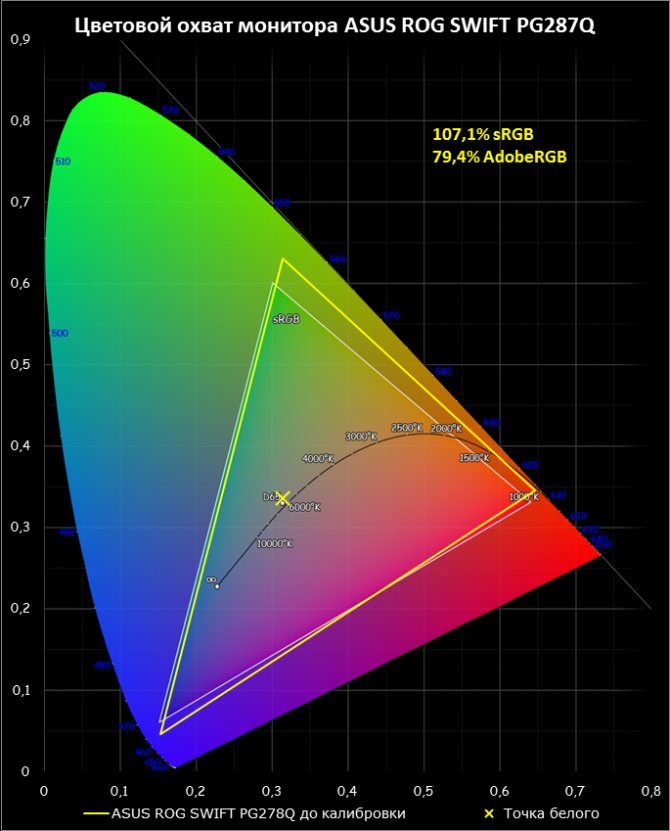

- Цветовой охват;

- Цветовую температуру;

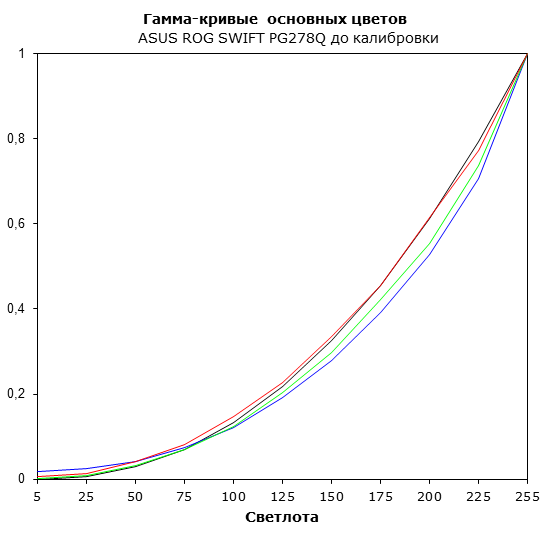

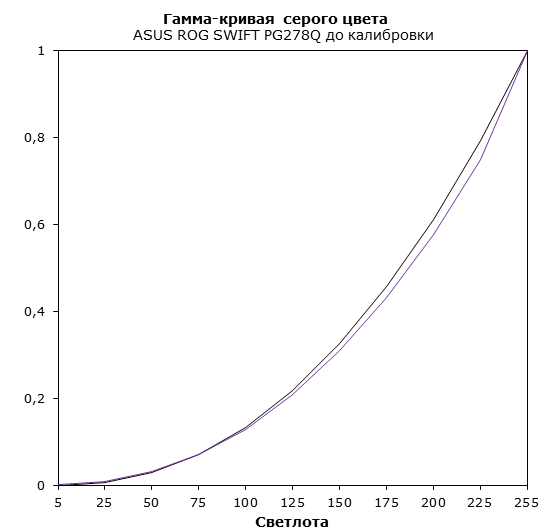

- Гамма-кривые трёх основных цветов RGB;

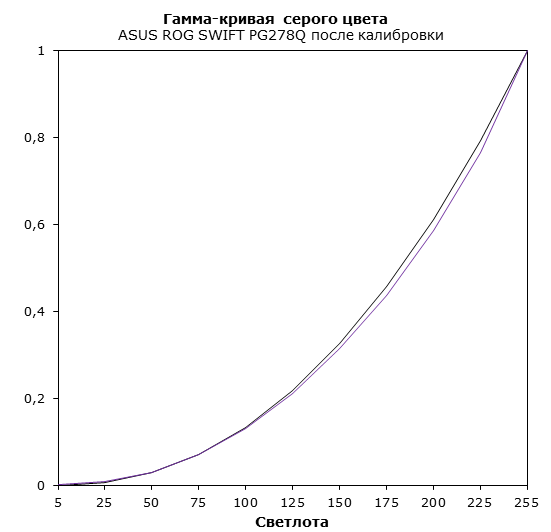

- Гамма-кривую серого цвета;

- Delta E (по стандарту CIEDE2000).

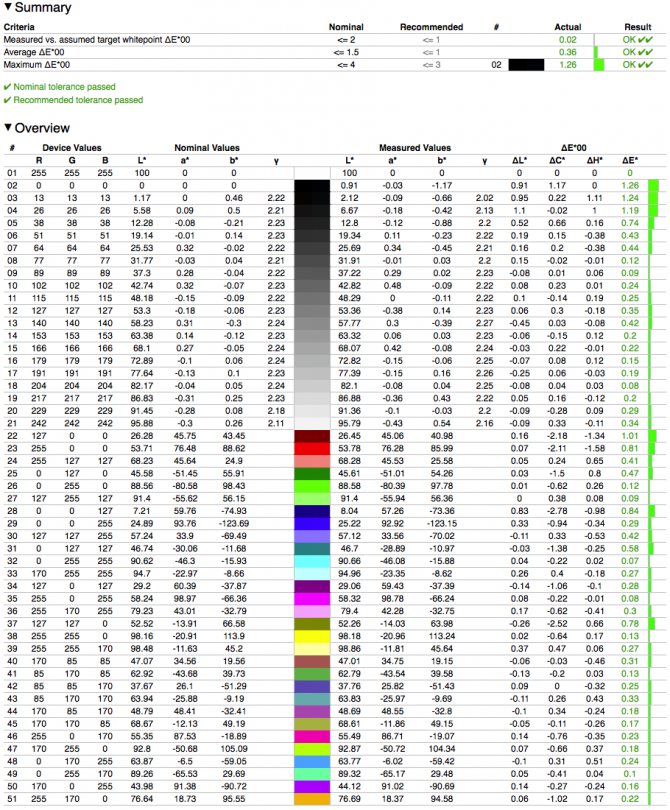

Для калибровки и анализа Delta E применяется графический интерфейс для Argyll CMS — DispcalGUI, последней версии на момент написания статьи. Все описанные выше измерения проводятся до и после калибровки. Во время тестов мы измеряем основные профили монитора — выставленный по умолчанию, sRGB (если доступен) и Adobe RGB (если доступен). Калибровка проводится в профиле, выставленном по умолчанию, за исключением особых случаев, о которых будет сказано дополнительно. Для мониторов с расширенным цветовым охватом мы выбираем режим аппаратной эмуляции sRGB, если он доступен. В последнем случае цвета конвертируются по внутренним LUT монитора (которые могут иметь разрядность вплоть до 14 бит на канал) и выводятся на 10-битную матрицу, в то время как попытка сузить цветовой охват до границ sRGB инструментами цветокоррекции ОС приведёт к снижению точности кодирования цвета. Перед началом всех тестов монитор прогревается в течение часа, а все его настройки сбрасываются до заводских.

Также мы продолжим нашу старую практику публикации профилей калибровки для протестированных нами мониторов в конце статьи. При этом тестовая лаборатория 3DNews предупреждает, что такой профиль не сможет на 100% исправить недостатки конкретно вашего монитора. Дело в том, что все мониторы (даже в рамках одной модели) обязательно будут отличаться друг от друга своими небольшими погрешностями цветопередачи. Изготовить две одинаковые матрицы невозможно физически — слишком уж они сложны. Поэтому для любой серьёзной калибровки монитора необходим колориметр или спектрофотометр. Но и «универсальный» профиль, созданный для конкретного экземпляра, в целом может поправить ситуацию и у других устройств той же модели, особенно в случае дешёвых дисплеев с ярко выраженными дефектами цветопередачи.

Углы обзора, равномерность подсветки

Первое, что интересовало нас в ASUS PG278Q, это углы обзора, ведь в мониторе используется TN-матрица — её самые большие проблемы всегда связаны с ними. К счастью, все оказалось не так уж плохо. Конечно, у IPS-матриц углы обзора побольше, но и ASUS PG278Q не приходилось часто поворачивать, чтобы устранить искажения контраста и цветопередачи.

А вот проблем с засветкой экрана разработчикам ASUS PG278Q избежать не удалось. У монитора есть небольшая засветка по всем четырём углам и в верхней части. Если на дисплее запущена игра, то разглядеть засветку будет непросто, но стоит запустить какой-нибудь фильм в тёмной комнате (с обычными вертикальными чёрными полосами сверху и снизу) — и дефект сразу становится заметным.

Тестирование без калибровки

Максимальная яркость у ASUS PG278Q составила 404 кд/м2 — даже больше, чем обещает производитель. Столь высокое значение оправдано поддержкой 3D, ведь при использовании активных затворных очков воспринимаемая яркость монитора может упасть в два раза. Максимальная яркость чёрного поля составила 0,40 кд/м2, что тоже весьма неплохо. В результате статическая контрастность колеблется около значения 1000:1 на всём диапазоне яркости подсветки. Отличный результат — столь высокая контрастность характерна для качественных IPS-матриц. MVA, правда, вне досягаемости.

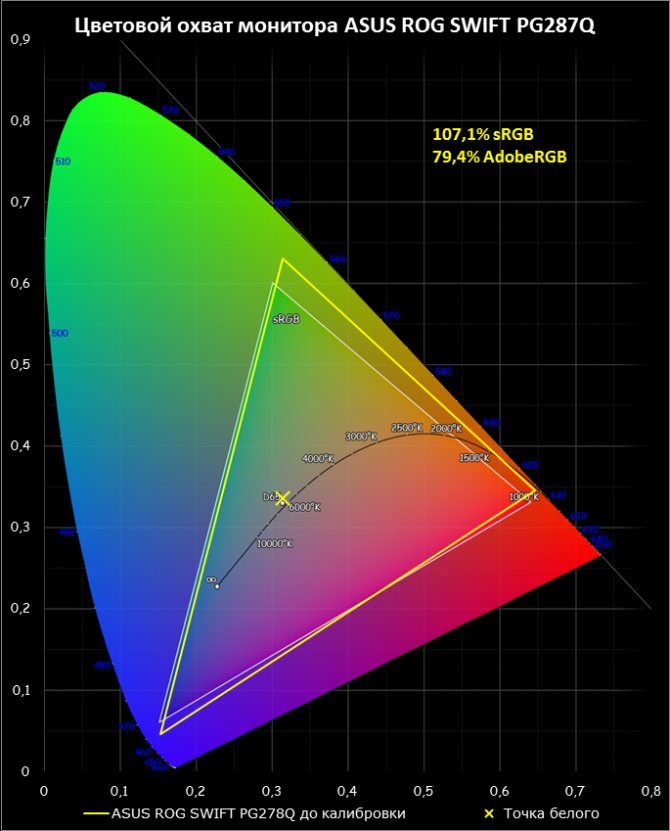

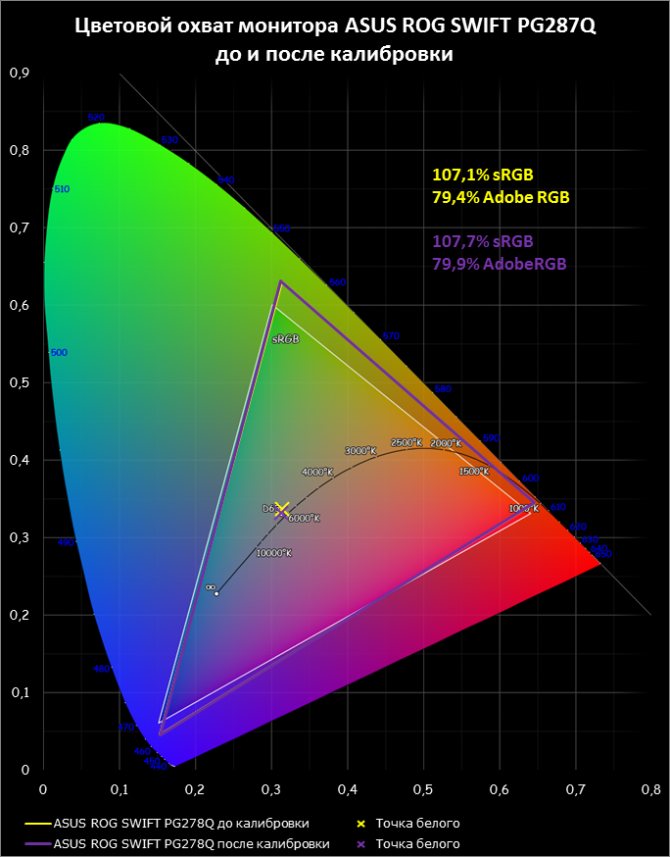

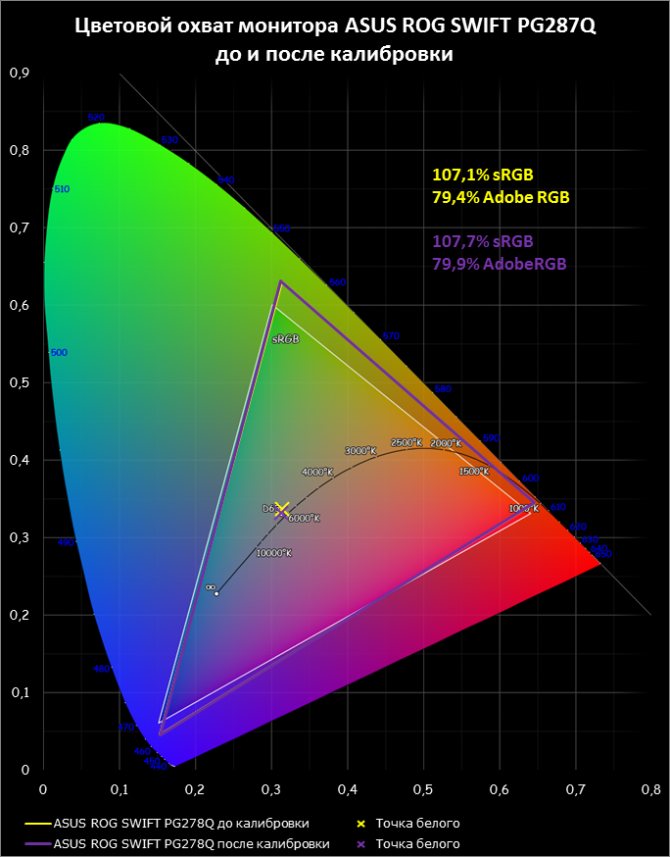

С цветовым охватом у нашего подопытного всё настолько хорошо, насколько требуется. Цветовое пространство sRGB покрыто на 107,1%. Точка белого находится рядом с эталонной точкой D65.

Если говорить об играх, то с цветовой палитрой у ASUS PG278Q полный порядок, а вот с профессиональной обработкой фото могут быть проблемы из-за немного перенасыщенных цветов в силу избыточного цветового охвата по сравнению с sRGB. Впрочем, рассматриваемый нами дисплей предназначен как раз для игр, поэтому не стоит обращать много внимания на этот недостаток.

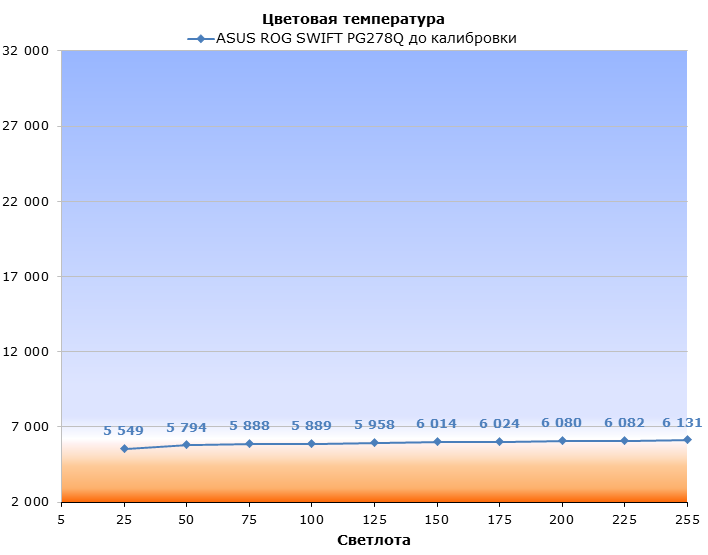

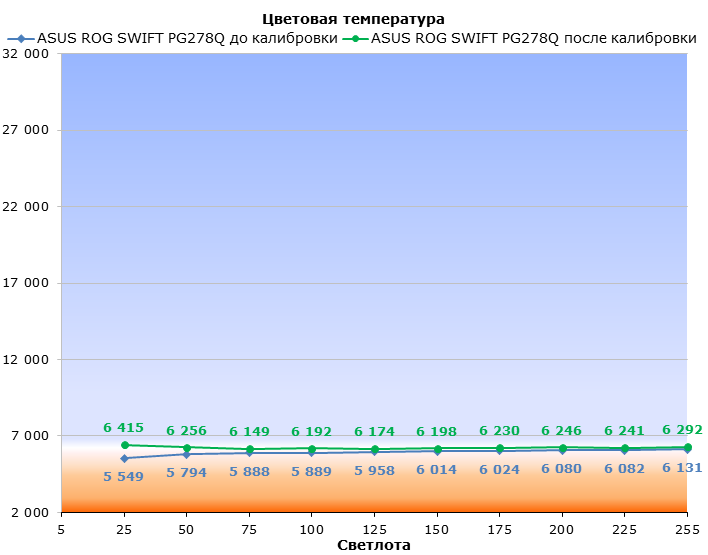

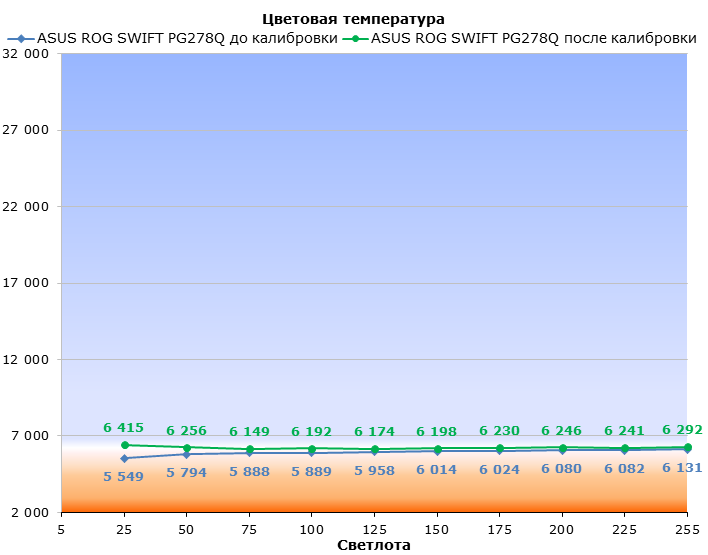

Цветовая температура ASUS PG278Q в ходе измерений держалась на уровне 6 000 К, что на 500 К ниже нормы. Это значит, что у светлых цветов может быть заметен лёгкий тёплый оттенок.

|

|

Только гамма-кривая красного цвета оказалась недалеко от эталона, а кривые синего и зелёного просели, хотя и старались держаться вместе. При этом с гаммой серого у монитора дела идут практически хорошо. При измерении тёмных тонов она практически не отклоняется от эталонной кривой, а при переходе к светлым — отходит, но не сильно.

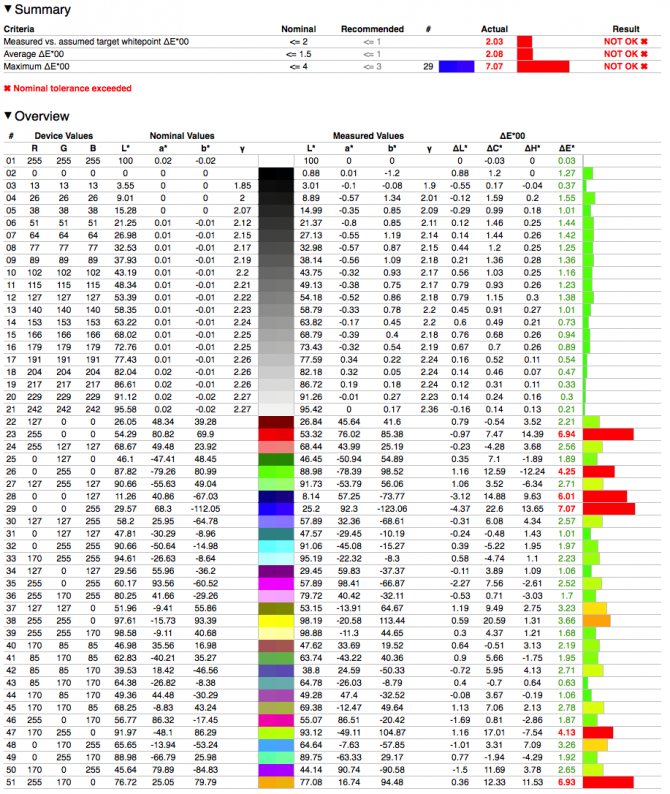

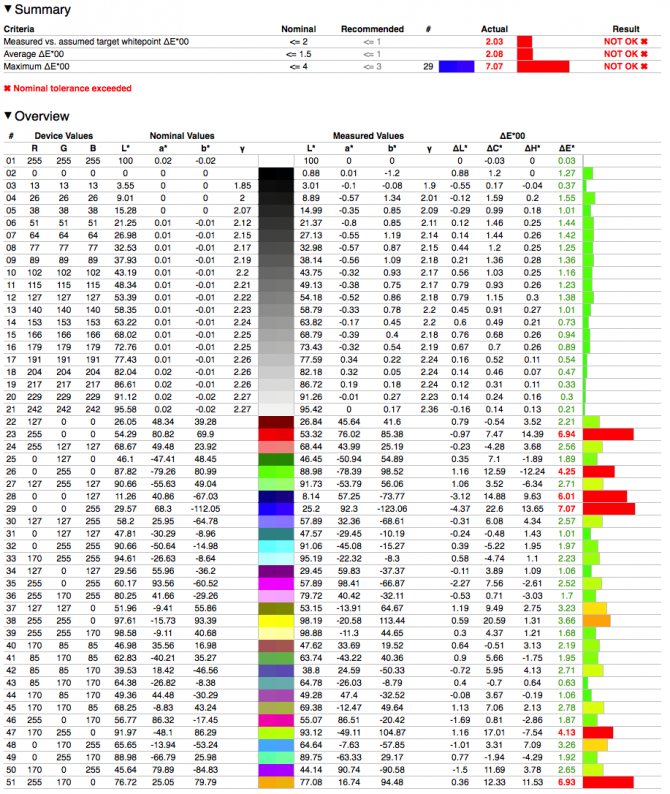

Среднее значение показателя точности цветопередачи Delta E составило 2,08 единицы, а максимальное — 7,07 единицы. Результаты, конечно, не самые лучшие, но, во-первых, ASUS PG278Q все-таки предназначен для игр, а не для обработки фото, во-вторых, для TN-матрицы полученные нами результаты вполне удовлетворительны.

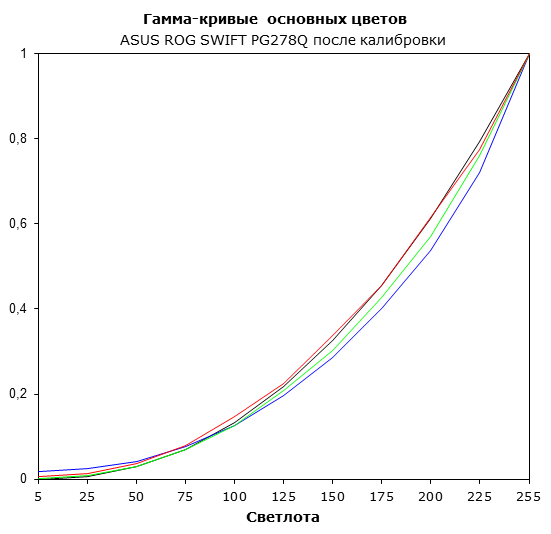

Тестирование после калибровки

Обычно после калибровки яркость белого падает, причём очень сильно — на 10% и более, даже у вполне качественных панелей. В случае с ASUS PG278Q она упала примерно на 3% — до 391 кд/м2. Яркость чёрного поля аппаратная калибровка не затронула. Как результат, статическая контрастность снизилась до 970:1.

Калибровка практически не повлияла на цветовой охват, а вот точка белого вернулась на положенное ей место, пускай и сдвинулась лишь совсем чуть-чуть.

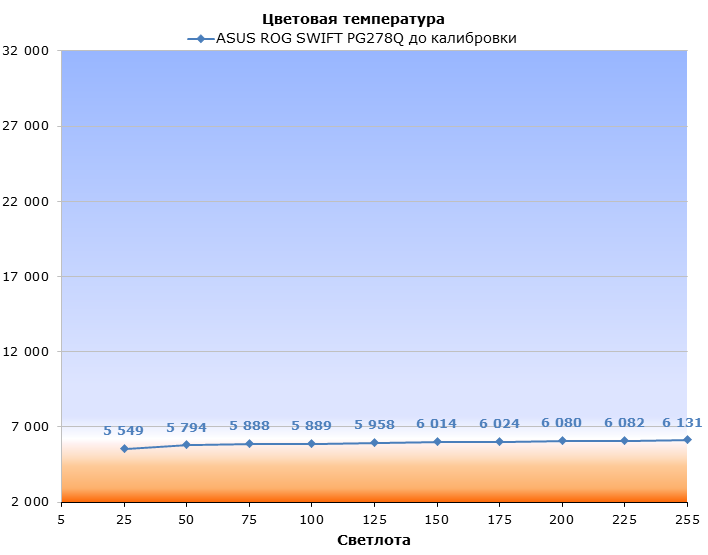

После калибровки цветовая температура немного поднялась, но до эталонной не дотянула. Теперь разрыв между измеренным и эталонным значением составил примерно 100—200 К вместо 500 К, что, впрочем, вполне терпимо.

| Гамма-кривые до калибровки | ||

|

| |

| Гамма-кривые после калибровки | ||

Положение трёх основных гамма-кривых, к сожалению, почти не изменилось после калибровки, тогда как гамма серого стала выглядеть немного лучше.

|

А вот на точности цветопередачи калибровка сказалась лучше всего. Cреднее значение Delta E опустилось до 0,36 единицы, максимальное — до 1,26 единицы. Великолепные результаты для любой матрицы, а уж для TN+Film — просто фантастика.

Тестирование G-Sync: методика

В руководстве по G-Sync от NVIDIA приведены настройки для тестирования в нескольких играх, при которых количество кадров в секунду будет колебаться между 40 и 60 FPS. Именно в таких условиях при частоте обновления 60 Гц возникает больше всего «фризов» со включенным V-Sync. Для начала мы сравним три сценария использования: с V-Sync, без него и с G-Sync — все на частоте 60 Гц.

Но вспомним, что подъём частоты обновления с 60 до 120/144 Гц сам по себе делает разрывы менее заметными без вертикальной синхронизации, а с V-Sync уменьшает «фризы» с 13 до 8/7 мс соответственно. Есть ли реальная польза от G-Sync по сравнению с V-Sync на частоте 144 Гц? Проверим и это.

Хотелось бы особо отметить, что, если верить описанию, в случае G-Sync частота обновления совершенно не имеет смысла. Поэтому не вполне корректно говорить, что мы, к примеру, сравнили V-Sync и G-Sync на частоте 60 Гц. V-Sync действительно был на частоте 60 Гц, а G-Sync означает обновление экрана по требованию, а не с определённым периодом. Но даже при включённом G-Sync мы все ещё можем выбирать частоту обновления экрана в панели управления драйвером. При этом FRAPS в играх при активации G-Sync показывает, что действует именно такой потолок частоты кадров, как если бы работал V-Sync. Получается, что эта настройка регулирует минимальное время жизни кадра и, соответственно, интервал обновления экрана. Грубо говоря, задаётся диапазон частот, в котором оперирует монитор, — от 30 до 60-144 Гц.

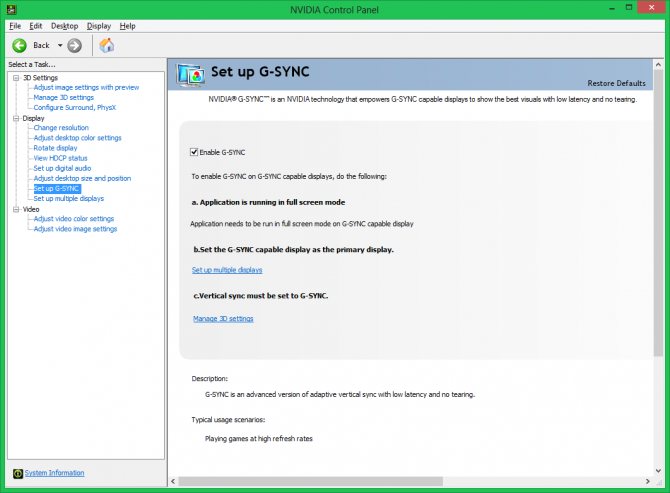

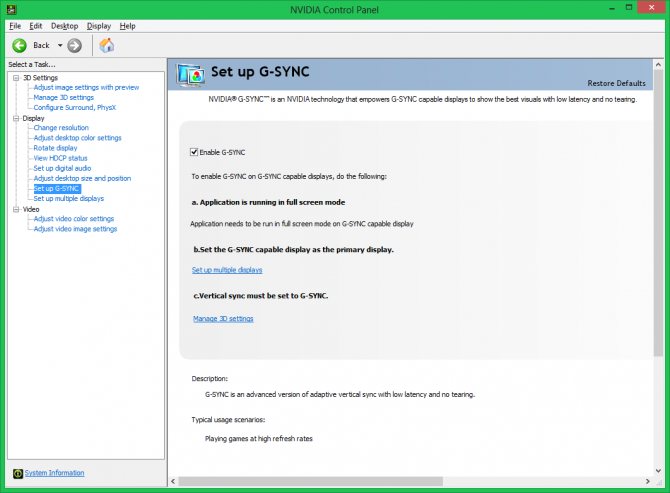

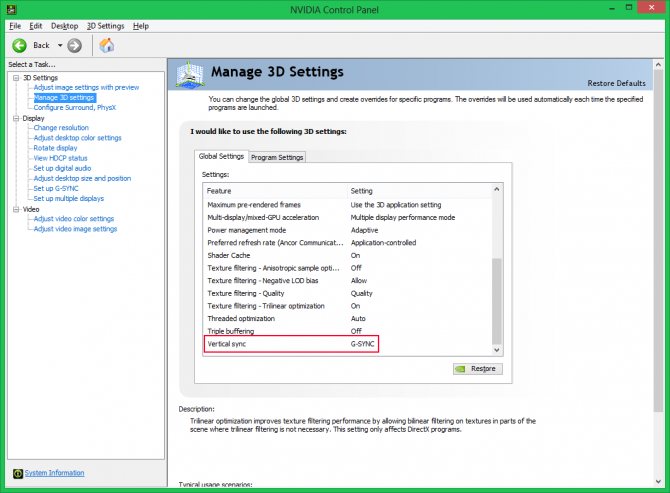

Для того чтобы включить G-Sync, необходимо зайти в панель управления NVIDIA, найти соответствующую ссылку в левом углу экрана и поставить галочку около единственного чекбокса. Технология поддерживается в драйверах для ОС Windows 7 и 8.

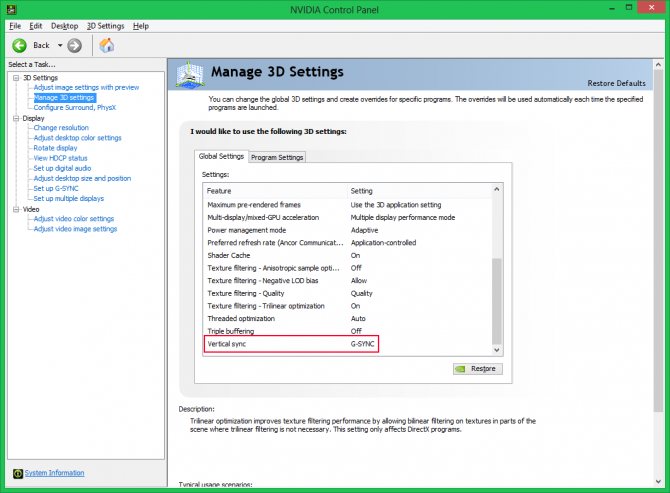

Затем надо убедиться, что в разделе «Настройки 3D» также включен G-Sync — его можно найти в подменю Vertical Sync.

На этом всё: функция G-Sync включилась для всех игр, запущенных в полноэкранном режиме, — в окне эта функция пока ещё работать не умеет. Для тестирования мы использовали стенд с графической картой GeForce GTX TITAN Black.

| Конфигурация тестового стенда | |

| CPU | Intel Core i7-3770K @ 3,9 ГГц (100×39) |

| Видеокарта | Nvidia GeForce GTX TITAN Black |

| Материнская плата | Intel DZ77GA-70K |

| Оперативная память | DDR3 AMD Radeon R9 2×8 Гбайт @ 1866 МГц |

| ПЗУ | Intel SSD 520 240 Гбайт |

| Блок питания | Corsair AX1200i, 1200 Вт |

| Охлаждение CPU | Thermalright Archon |

| Операционная система | Windows 8 X64 |

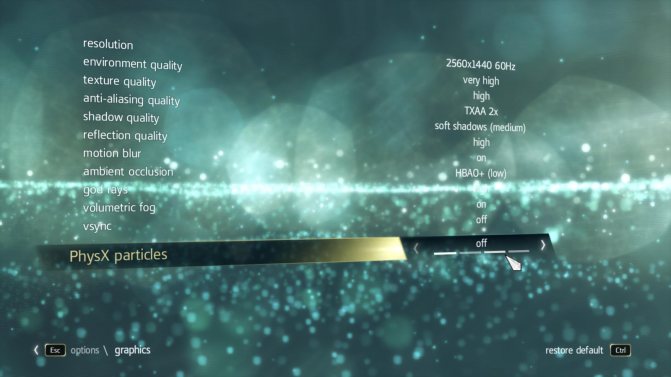

Испытания проводились в играх Assasin’s Creed: Black Flag, а также в Counter-Strike: Global Offensive. Новую технологию мы тестировали двумя способами: просто играли, а затем устроили охоту на разрывы с помощью скрипта, который плавно перемещал игровую камеру, то есть «двигал мышкой» по горизонтали. Первый способ позволял оценить ощущения от G-Sync «в бою», а второй — более наглядно увидеть разницу между включенной/выключенной вертикальной синхронизацией и G-Sync.

G-Sync в Assasin’s Creed: Black Flag, 60 Гц

После выставления настроек, рекомендованных NVIDIA, частота смены кадров держалась на уровне 35—65 FPS, что отлично подходило для тестов.

Настройки графики, рекомендованные NVIDIA для тестирования G-Sync в Assasin’s Creed: Black Flag

Без V-Sync и G-Sync при частоте 60 Гц разрывы были отлично заметны почти при любом движении камеры.

Разрыв заметен в правой верхней части кадра, около мачты корабля

При включении V-Sync разрывы изображения пропали, но появились «фризы», что не пошло на пользу геймплею.

Двоящаяся мачта корабля на фото — один из признаков «фриза»

После включения G-Sync разрывы и «фризы» пропали полностью, игра стала работать плавнее. Конечно, периодическое уменьшение частоты кадров до 35—40 FPS было заметно, но благодаря синхронизации дисплея и видеокарты не вызывало столь ощутимых тормозов, как с вертикальной синхронизацией.

Однако, как говорится, лучше один раз увидеть, чем сто раз услышать, поэтому мы сделали короткое видео, на котором показана работа новых «Ассасинов» с включённой и выключенной вертикальной синхронизацией, а также с G-Sync. Конечно, видео не может передать «живые» впечатления полностью хотя бы из-за съёмки на частоте 30 кадров в секунду. Кроме того, камера «видит» мир иначе, чем глаз человека, поэтому на видео могут быть заметны артефакты, которые в реальном мире не разглядеть, — например, двоение изображения. Тем не менее мы постарались сделать это видео максимально наглядным: по крайней мере наличие или отсутствие разрывов на нём вполне заметно.

Теперь запустим Assasin’s Creed: Black Flag с минимальными настройками и посмотрим, что изменилось. Количество кадров в секунду в таком режиме игры не превышало 60 FPS — выставленной частоты обновления экрана. Без включённой вертикальной синхронизации на экране были заметны разрывы. Но стоило включить V-Sync, как разрывы пропали и «картинка» стала выглядеть практически так же, как и при G-Sync.

При выставлении максимальных настроек графики количество кадров в секунду стало колебаться около 25—35 FPS. Разумеется, сразу же вернулись разрывы без V-Sync и «фризы» с ним. Исправить эту ситуацию не смогло даже включение G-Sync — при таком низком количестве FPS тормоза порождает уже сам GPU.

G-Sync в Assasin’s Creed: Black Flag, 144 Гц

При отключенных V-Sync и G-sync на экране можно было найти разрывы, но благодаря частоте обновления 144 Гц их стало гораздо меньше, чем раньше. При включении V-Sync пропадали разрывы, но чаще стали встречаться «фризы» — почти как и при частоте обновления экрана в 60 Гц.

Включение G-Sync, как и раньше, смогло исправить ситуацию, но самое сильное улучшение картинки было заметно лишь при высокой частоте кадров — от 60 FPS и выше. Вот только без снижения настроек или добавления второй видеокарты уровня GeForce GTX Titan Black достичь такой высокой частоты кадров не получалось.

G-Sync в Counter-Strike: Global Offensive, 60 и 144 Гц

В сетевых играх на игровой процесс и качество изображения влияют не только видеокарта и монитор, но и пинг — чем он выше, тем больше задержка «отклика» игры. Во время наших тестов пинг находился на уровне 25—50 мс, а частота кадров во время теста колебалась около 200 FPS.

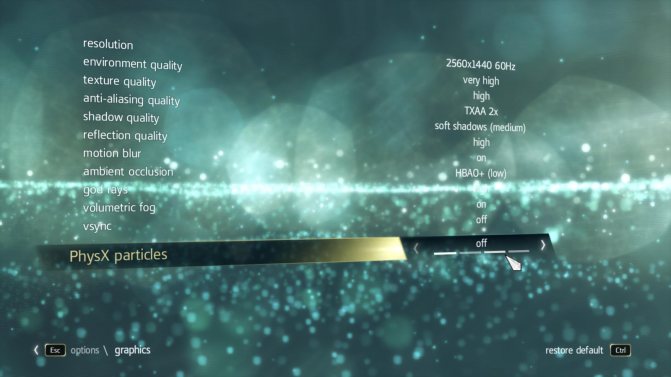

Настройки изображения, использованные в Counter-Strike: Global Offensive

Без использования G-Sync и V-Sync в CS, как и в Assasin’s Creed, наблюдались разрывы. При включении V-Sync при частоте 60 Гц играть стало сложнее — частота кадров упала до 60 FPS, да и бегать игровой персонаж стал неровно из-за большого количества «фризов».

При включении G-Sync фреймрейт так и остался на уровне 60 кадров в секунду, но «фризов» стало гораздо меньше. Нельзя сказать, что они пропали совсем, но портить впечатление от игры перестали.

Теперь увеличим частоту обновления экрана и посмотрим, что изменится. При отключенных G-Sync и V-Sync на 144 Гц разрывов стало гораздо меньше, чем при 60 Гц, но полностью они не исчезли. Зато при включении V-Sync пропали все разрывы, а «фризы» стали практически незаметными: играть в таком режиме очень комфортно, да и скорость передвижения не снижается. Включение G-Sync и вовсе превратило изображение в конфетку: геймплей стал настолько плавным, что даже 25-мс пингстал сильно влиять на игровой процесс.

Тестирование режима ULMB

Ultra Low Motion Blur включается из меню монитора, но предварительно требуется отключить G-Sync и выставить частоту обновления экрана на отметке 85, 100 или 120 Гц. Более низкие или высокие частоты не поддерживаются.

Практическое применение этой «фишки» очевидно: текст на сайтах меньше смазывается во время прокрутки, а в стратегиях и прочих RTS-играх движущиеся юниты выглядят более детально.

ASUS ROG SWIFT PG278Q в 3D

ASUS ROG SWIFT PG278Q — первый в мире монитор, способный воспроизводить стереоскопическую картинку при разрешении 2560х1440 благодаря интерфейсу DisplayPort 1.2. Тоже, в принципе, немаленькое достижение. К сожалению, у монитора нет встроенного ИК-трансмиттера, поэтому мы взяли трансмиттер из комплекта NVIDIA 3D Vision, а очки — из комплекта 3D Vision 2. Такая связка заработала без проблем, и мы смогли протестировать стереоскопическое 3D как следует.

Никакого эффекта ghosting и прочих артефактов, встречающихся у псевдообъёмного видео, мы не нашли. Разумеется, иногда в играх некоторые объекты находились на неправильной глубине, но к недостаткам монитора это отнести никак нельзя. На ASUS PG278Q можно как смотреть стереофильмы, так и играть в подобные игры. Главное — чтобы видеоадаптер потянул.

Мониторы с поддержкой этой технологии

Ушли в прошлое те времена, когда пользователи убивали свое зрение, часами глядя в древние ЭЛТ-мониторы. Теперешние модели отличаются элегантностью и безвредностью. Так почему бы не добавить им немного новых технологий? Первый монитор с поддержкой NVIDIA G-Sync и разрешением 4К был выпущен компанией Acer. Новинка произвела изрядный фурор.

Пока еще качественные мониторы с G-Sync довольно редки. Но в планах у производителей имеется задумка сделать эти устройства стандартными. Скорее всего, через пять лет мониторы с поддержкой данной технологии станут стандартным решением даже для офисного ПК. Ну а пока остается только поглядывать на эти новинки и ждать их повсеместного распространения. Именно тогда они подешевеют.

После этого мониторы с поддержкой G-Sync начали клепать все, кому не лень. Появились даже бюджетные модели с этой технологией. Хотя что толку от этой технологии на бюджетном экране с плохой матрицей? Но, как бы то ни было, такие модели имеют место. Оптимальным вариантом для данной опции является монитор 144 Гц (G-Sync на нем работать будет в полную силу).

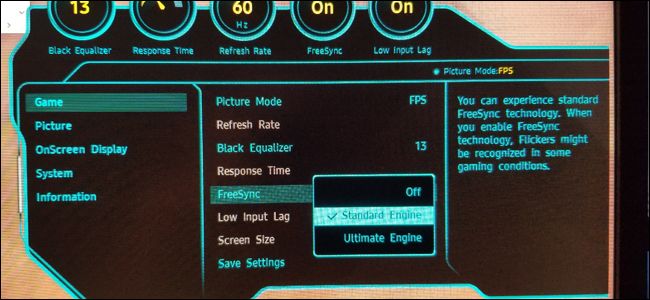

Как включить режим «G-SYNC-совместимый» на любом мониторе FreeSync

Вот что вам нужно, чтобы включить режим совместимости с G-SYNC, если ваш монитор не сертифицирован NVIDIA:

- Монитор с поддержкой FreeSync (адаптивная синхронизация)

- Графическая карта NVIDIA GTX или RTX (ноутбуки с внутренними дискретными картами тоже подойдут)

- Кабель DisplayPort, соединяющий их (Mini-DisplayPort в порядке)

- Драйверы для графических процессоров NVIDIA, 417.71 или новее

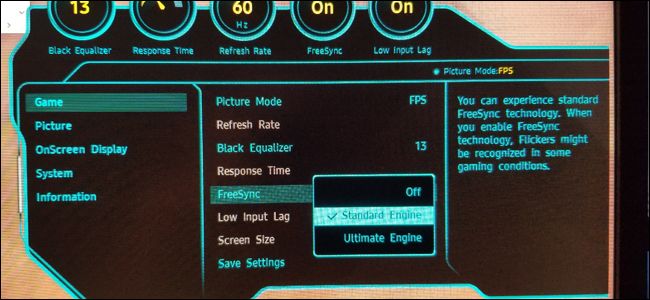

Убедившись, что ваш монитор совместим с FreeSync, и вы используете кабель DisplayPort, проверьте экранное меню вашего монитора. Это тот, который вы активируете с помощью физических кнопок на мониторе. Зайдите в меню и убедитесь, что функция Adaptive Sync или FreeSync включена.

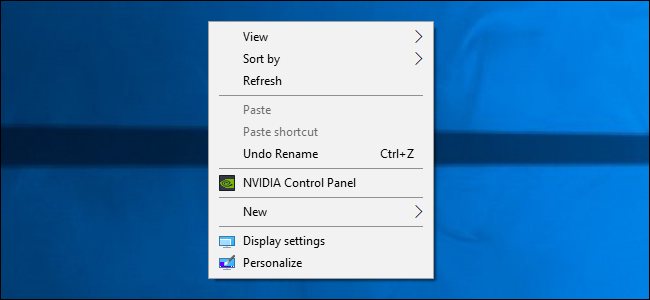

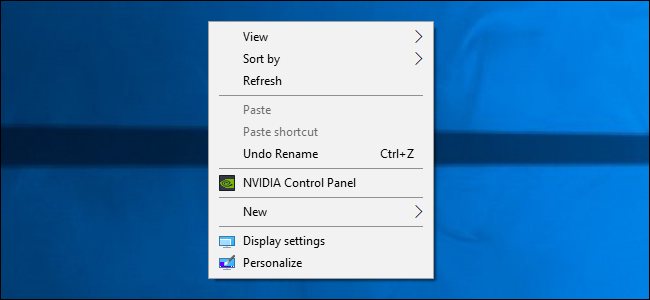

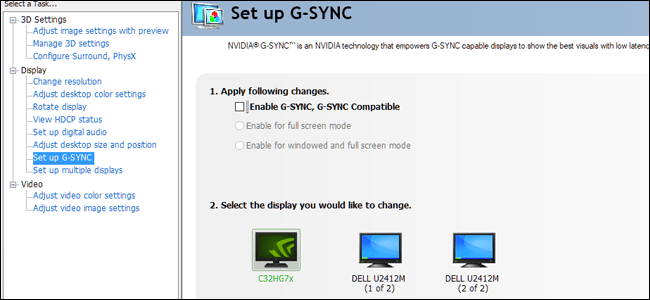

Теперь в Windows откройте панель управления NVIDIA, щелкнув правой кнопкой мыши на рабочем столе и выбрав «Панель управления NVIDIA.»

Вы также можете найти ярлык для панели управления NVIDIA в меню «Пуск» или в виде значка на панели управления Windows.

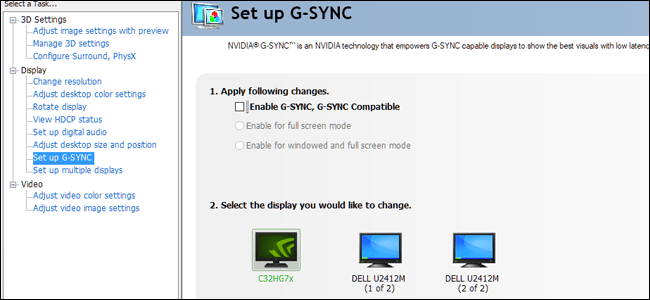

На панели управления NVIDIA вы должны увидеть «Настройка G-SYNC» в меню «Дисплей» с левой стороны. Если вы не видите «Настроить G-SYNC» в качестве опции и уверены, что он включен вашим монитором, вам может потребоваться установить драйверы для вашего монитора вручную.

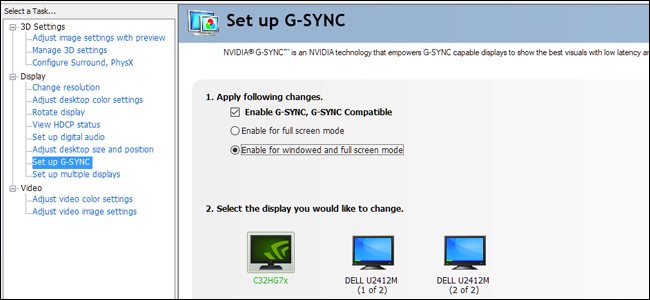

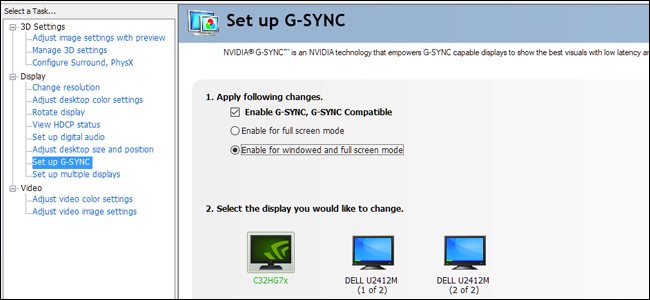

На экране настройки G-SYNC убедитесь, что выбран основной монитор, если у вас их несколько. Установите флажок «Включить G-SYNC, совместим с G-SYNC». Выберите, следует ли включить его только для полноэкранного режима или как для оконного, так и для полноэкранного режима, в зависимости от того, как вы отображаете свои игры.

Нажмите «Применить», чтобы включить G-SYNC/FreeSync. Тебе хорошо идти! Наслаждайтесь плавным геймплеем в ваших любимых играх. Обратите внимание, что некоторые игры могут работать лучше или хуже, в зависимости от того, запускаете ли вы их в полноэкранном или оконном режиме («полноэкранное оконное» считается для этой цели оконным). Вы можете вернуться и изменить эту настройку в Панели управления NVIDIA, если у вас возникли проблемы.

Лучшие мониторы с G-Sync

Мониторы с технологией G-Sync выделяются в особую линейку устройств. Они должны обладать характеристиками, нужными для полноценной работы данной опции. Понятно, что далеко не все экраны справятся с такой задачей. Уже сейчас определились несколько лидеров по производству таких мониторов. Их модели получились очень удачными.

К примеру, монитор ASUS RoG Swift PG348Q G-Sync относится к ярким представителям данной линейки. Это устройство относится к премиум-классу. Почему? Судите сами. Диагональ экрана составляет 34 дюйма, разрешение – 4К, контрастность – 1:1000, 100 Гц, время отклика матрицы – 5 мс. К тому же экран изогнут. Многие хотели бы заполучить себе этого «монстра». Понятно, что он будет на ура справляться с технологией G-Sync. Ему пока нет аналогов. Можно спокойно назвать его лучшим в своем классе и не ошибиться.

Вообще, G-Sync мониторы ASUS сейчас находятся на вершине «Олимпа». Еще ни один производитель не смог переплюнуть эту компанию. И вряд ли когда-нибудь это получится. ASUS можно назвать первопроходцем в этом плане. Их мониторы, поддерживающие G-Sync, разлетаются, как горячие пирожки.

Будущее G-Sync

Сейчас технологию G-Sync активно пытаются внедрить в ноутбуки. Некоторые производители даже выпустили пару таких моделей. Причем они могут работать без платы G-Sync в мониторе. Что и понятно. Все-таки у ноутбука несколько другие конструктивные особенности. Там вполне достаточно видеокарты с поддержкой данной технологии.

Вероятно, вскоре изрядное место в компьютерной промышленности займет именно NVIDIA G-Sync. Мониторы с этой технологией должны подешеветь. В конце концов эта опция должна стать повсеместно доступна. Иначе какой смысл в ее разработке? В любом случае пока все не так радужно. Есть некоторые проблемы по внедрению G-Sync.

В будущем технология G-Sync станет такой же обыденной вещью, которой был для нас когда-то VGA-порт для подключения монитора. А вот всяческие «вертикальные синхронизации» на фоне этой технологии выглядят вопиющим анахронизмом. Мало того что эти устаревшие технологии не могут обеспечить удовлетворительное качество картинки, так они еще и «кушают» немалое количество системных ресурсов. Определенно, с появлением G-Sync их место на помойке истории.

Что такое вертикальная синхронизация?

Vsync или вертикальная синхронизация напрямую связана с компьютерными играми и отображением графики. В этом пространстве существует такое понятие, как количество кадров в секунду — FPS. Монитор и видеокарта имеют свои значения FPS. Для лучшего отображения графики, параметры частоты должны совпадать.

Если включить вертикальную синхронизацию, то количество кадров в секунду, которые выдает видеокарта, будет ограничено частотой обновления монитора. Это позволит создать более плавную картинку, которую пользователь хочет видеть в приложениях.

Если подобную функцию нельзя включить, тогда стоит воспользоваться тройной буферизацией. Только в этом случае можно задействовать Vsync.

Отзывы

Как говорят специалисты, эффект, который производит G-Sync, очень трудно описать словами. Это как раз из категории «лучше один раз увидеть». Но, судя по отзывам, с применением этой технологии плавность картинки заметна даже невооруженным глазом. Безусловно, геймеры рады такому нововведению. Некоторые не могут понять, как узнать, поддерживает ли монитор G-Sync. Обычно это написано на самом мониторе либо отмечено в сопроводительной документации.

В большинстве своем отзывы о новой технологии сугубо положительные. Некоторых не устраивает только изрядная дороговизна нового комплекта. Но так было и будет всегда. И от этого никуда не деться. Чтобы увидеть снижение цен на данную технологию, нужно дождаться, пока NVIDIA G-Sync станет массовым продуктом. А нужно для этого как минимум пару лет.

Альтернативные технологии

Параллельно с проектом G-Sync развивается еще один способ решения проблем с выводом видео. Разработала его небезызвестная компания AMD. Он называется FreeSync и, в отличие от G-Sync, не нуждается ни в какой дополнительной плате в мониторе. То есть G-Sync-монитор совершенно не нужен. Все, что нужно, уже установлено в разъем mini Display Port. Главное достоинство этой технологии в том, что AMD не скрывает своих наработок, и любой может использовать и дорабатывать FreeSync. AMD явно нацелилась на массовость.

А вот NVIDIA подобным альтруизмом не страдает. Мало того что технология проприетарная, так за нее еще придется отвалить немалую сумму. Предложение от AMD в этом плане выглядит как-то симпатичнее. Тем более что технически результаты совершенно идентичны. Но кто победит в этой борьбе, будет видно чуть позднее.

V-Sync на графике AMD

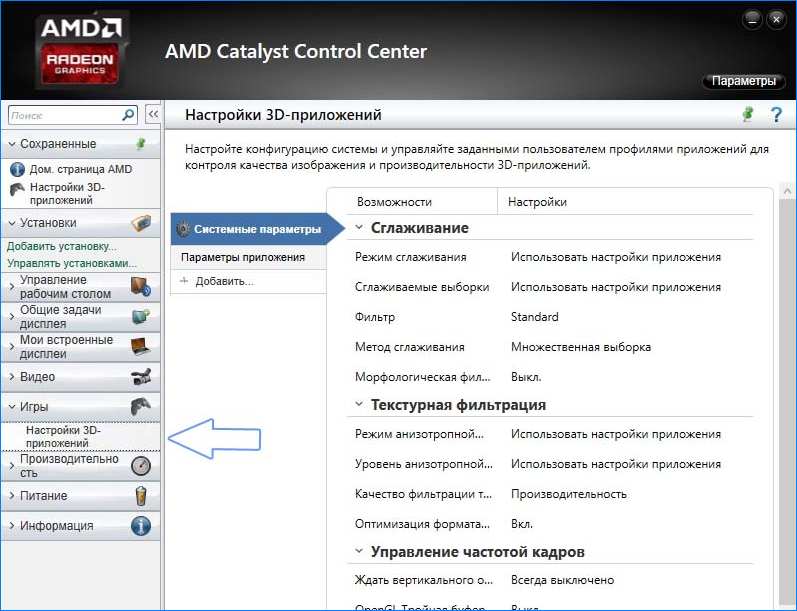

В случае с видеокартами AMD выглядит совершенно так же, как и в Nvidia. Кликните правой кнопкой мыши на рабочем столе, а затем перейдите в Панель Panel Catalyst Control Center.

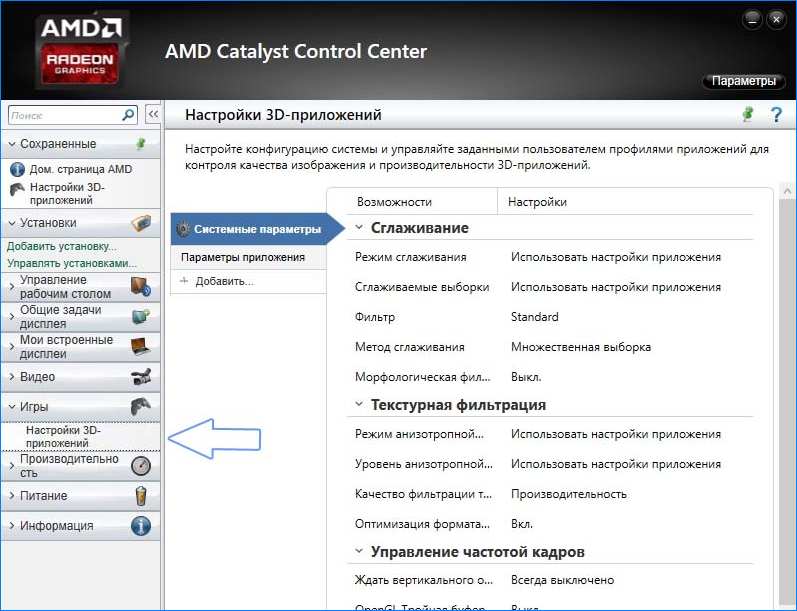

Затем раскрываем слева вкладку «Игры» и выбираем «Настройки 3D-приложений». Справа отобразится список доступных вариантов, которые можно принудительно включить с позиции настроек видеокарты AMD Radeon. Когда находимся на вкладке «Системные параметры», то выбираем для всех.

Если нужно установить параметры индивидуально для каждой игры в отдельности, то следует нажать на кнопку «Добавить» и указать EXE файл. Она будет добавлена в список в виде новой закладки и при переходе на нее можно задать параметры только для этой игры.

Когда выбрали вкладку с добавленным приложением или системными параметрами (общими), то найдите в списке опцию «Жди на вертикальное обновление». Появится поле для выбора, где сможем принудительно включить или отключить эту опцию.

Проблемы G-Sync

Какая новая разработка без проблем? Такого не бывает. Вот и у G-Sync не так все радужно. Пока известна только одна серьезная проблема в этой технологии. А именно: адаптер G-Sync неадекватно работает на высоких частотах. Причем это касается и высокочастотных мониторов, и работы самого GPU на повышенных частотах.

Сейчас компания пытается всячески исправить ситуацию. Пока предпринимаются попытки программно исправить баг с помощью правки драйверов. Если это не поможет, компания перейдет к модифицированию аппаратной части адаптера. Возможно, в этом виноват и сам G-Sync-монитор. Поскольку технология еще досконально не изучена, трудно сказать, что послужило причиной этой проблемы. Но NVIDIA справится с этим, как и всегда.

AMD FreeSync vs Nvidia G-Sync

Технология динамического изменения частоты обновления экрана есть и у конкурента AMD – компании Nvidia, и называется она G-Sync. Принцип работы FreeSync и G-Sync во многом похож, но у AMD управление синхронизацией возложено на видеопроцессор, а у Nvidia – на монитор, в который встроен специальный контроллер. Это обуславливает достоинства и недостатки обеих технологий.

Итак, за счет чего FreeSync выигрывает у G-Sync и наоборот:

- Мониторы и FreeSync не требуют установки дорогостоящего контроллера, а значит, обходятся дешевле и для производителя, и для покупателя. Цена на аппараты, «заточенные» под AMD, меньше на целых $80-100.

- За использование технологии FreeSync, в отличие от G-Sync, производители оборудования не платят лицензионные отчисления, поэтому его экосистема охватывает все большее количество разнообразных устройств. Сегодня это не только мониторы для ПК, но и ноутбуки, и телевизоры.

- FreeSync поддерживает частоту обновления дисплея в диапазоне 30-240 Hz, а G-Sync – только 30-144 Hz. Для современных игр эта разница не слишком актуальна, но у AMD есть приличный задел на будущее.

- G-Sync совместим с гораздо большим количеством моделей видеокарт, включая устаревшие, такие, как GTX 650 Ti.

Так что же лучше: FreeSync или G-Sync? Применение обеих технологий дает картинку примерно одинакового качества, поэтому назвать одну явным лидером, а вторую отстающей, увы, не получится. Графика в игре зависит от многих факторов и в большей степени – от характеристик, производительности, сочетания железа, также от свойств самой игры. Технологии улучшения графики только раскрывают заложенный в устройства потенциал. Если вам больше нравится продукция Nvidia, значит, для вас лучше G-Sync, если AMD – то FreeSync. И то, и другое однозначно неплохо, так что лучший помощник в выборе – ваш личный вкус.

Резюме

У технологии NVIDIA G-Sync определенно есть будущее. Она будет популярна у заядлых игроков и тех, кто любит качественное изображение. Несмотря на потуги конкурентов создать что-либо аналогичное, можно смело сказать, что NVIDIA на голову их выше, так как делает все качественно. Лучше дороже, но качественнее, чем дешевле и топорно. Пока G-Sync не очень распространенная технология, но лет через пять каждый компьютер будет ее использовать. Поэтому стоит задуматься о том, чтобы модифицировать свой ПК прямо сейчас и оказаться в числе «первопроходцев». Конечно, это потребует немалых финансовых затрат, но если вы истинный ценитель качественного изображения на компьютере, то для вас игра стоит свеч.